Zainstalowany na kilku superkomputerach (staną m.in. w Finlandii, Włoszech i w Hiszpanii), cyfrowy bliźniak ma mieć działającą na tych samych zasadach atmosferę, hydrosferę, kriosferę i lądy. Dzięki temu możliwe będzie przewidywanie nawet z dwuletnim wyprzedzeniem powodzi, suszy i pożarów.

Panunijne przedsięwzięcie bazować ma na systemie obliczeniowym tworzonym w ramach EuroHPC (Europejskie Wspólnego Przedsięwzięcia w dziedzinie Obliczeń Wielkiej Skali) w który na lata 2019-2020 przeznaczono 1,1 mld euro. Powzięta w 2018 roku inicjatywa ma zrównać szanse UE w wyścigu mocy superkomputerów który wygrywają obecnie USA, Chiny i Japonia.

Opracowaniem maszyny, która zostanie umieszczona m.in. w fińskim centrum danych w Kajaani, zajmuje się konsorcjum LUMI do którego należy też Polska. Reprezentuje nas Akademickie Centrum Komputerowe Cyfronet Akademii Górniczo-Hutniczej w Krakowie.

- Planowana moc obliczeniowa superkomputera EuroHPC to ok. 200 PFlops, czyli 0,2 EFlops. Ta wartość oznacza, że będzie on ok. 10 razy szybszy od najszybszego superkomputera działającego obecnie w Europie, szwajcarskiego Piz Daint. 1 EFlops (eksaflops) to 1018 operacji zmiennoprzecinkowych (jedynka i 18 zer) wykonywanych przez superkomputer w ciągu sekundy – informuje rządowy serwis KPK, Krajowy Punkt Kontaktowy Programów Badawczych UE.

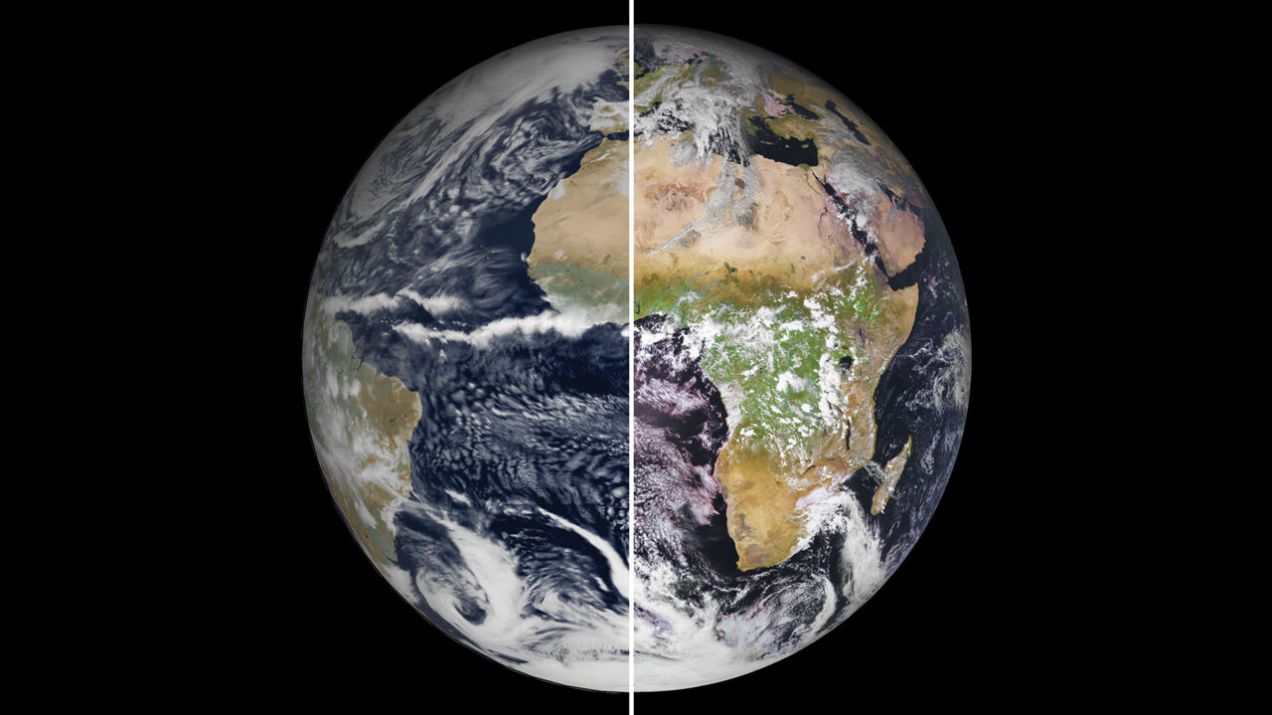

Ostateczne techniczne szczegóły projektu zostaną ogłoszone pod koniec października. Wiadomo m.in. że Desitnation Earth będzie operować w skali dużo większej niż istniejące modele klimatyczne, np. atmosfera Ziemi będzie renderowana w sześcianach o boku 1km. O ile ”standardowy” model pogodwy posługuje się rozdzielczością 50 czy 100 km, najdokładniejszy istniejący w UE używany przez Europejskie Centrum Prognoz Średnioterminowych (ECMWF) działa na 9 km.

- Rozdzielczość 1000 metrów nowego modelu pozwoli pracować na bezpośrednio renderdowanych ruchach konwekcyjnych zamiast na przybliżeniu algorytmicznym – zauważa czasopismo ”Science”.

Magazyn przypomina, że gdy w Japonii zaczęto pracować na globalnym modelu klimatycznym z rozdzielczością 1 km, pozwalającego symulować burze i wiry powietrzne, zaczęto z większą dokładnością prowadzić krótkookresowe przewidywania opadów.

Kolejny problem z dostępnym dziś modelowaniem klimatycznym dotyczy niemożności wykorzystania szczegółowych danych o temperaturze i ciśnieniu pozyskiwanych z satelitów, stacji pogodowych, samolotów i boi oceanicznych.

Duży poziom uszczegółowienia lokalnie zbieranych danych nie pokrywa się z siatką modelu o małej rozdzielczości. Destinantion Earth będzie działać w odpowiedniej skali by ”skorzystać” z już istniejącego strumienia informacji pogodowych, choćby z programu ESA Copernicus.

Duża rozdzielczość nie jest jedynym powodem, dla którego symulacja działać będzie na kilku superkomputerach. Cyfrowa Ziemia ma pokazywać w czasie rzeczywistym poziom zanieczyszczeń w atmosferze, wzrost zbóż, pożary lasów i inne zjawiska wpływające na pogodę i klimat.

- Jeżeli jutro wybuchłby wulkan, będziemy mogli ocenić ryzyko wystąpienia mniejszych opadów w rejonie tropików za kilka miesięcy – tłumaczy w ”Science” Francisco Doblas-Reyes z Barcelona Supercomputing Center, w którym działa superkomputer MareNostrum.

Nikt nie będzie symulował zachowań ludzi na poziomie jednostki, ale model uwzględniać będzie gromadzone na żywo dane na temat zużycia energii, komunikacji drogowej i ruchów mas ludzkich rejestrowanych zgodnie z sygnałami z ich telefonów komórkowych.

Cel ostateczny to pokazanie rządzącym dynamicznych zależności między zmianami klimatu a działaniami ludzi i sytuacji, gdy to my możemy zmieniać bieg tych zmian. Czy skasowanie dopłat do biopaliwa może wpłynąć na wycinkę lasów? Czy susze doprowadzą do masowych migracji?

– My tutaj przechodzimy z przewidywania tego, jaka pogoda będzie, do przewidywania tego, co ta pogoda zrobi – wyjaśnia Erin Coughlan de Perez, klimatolożka w holenderskim Centrum Klimatycznym Czerwonego Krzyża i Czerwonego Półksiężyca.